Verfälschte Studie zur Tauglichkeit grundrechtswidriger Techniken

Am Berliner Bahnhof Südkreuz testen ab heute die Deutsche Bahn, das Bundesministerium des Innern und die Bundespolizei in Kooperation mit dem Bundeskriminalamt, ob es möglich ist, mit biometrischer Gesichtserkennung im öffentlichen Raum nach Menschen zu fahnden. In einer späteren Phase des Projektes sollen zusätzlich Verhaltenserkennung und Verhaltensbewertung zum Einsatz kommen.

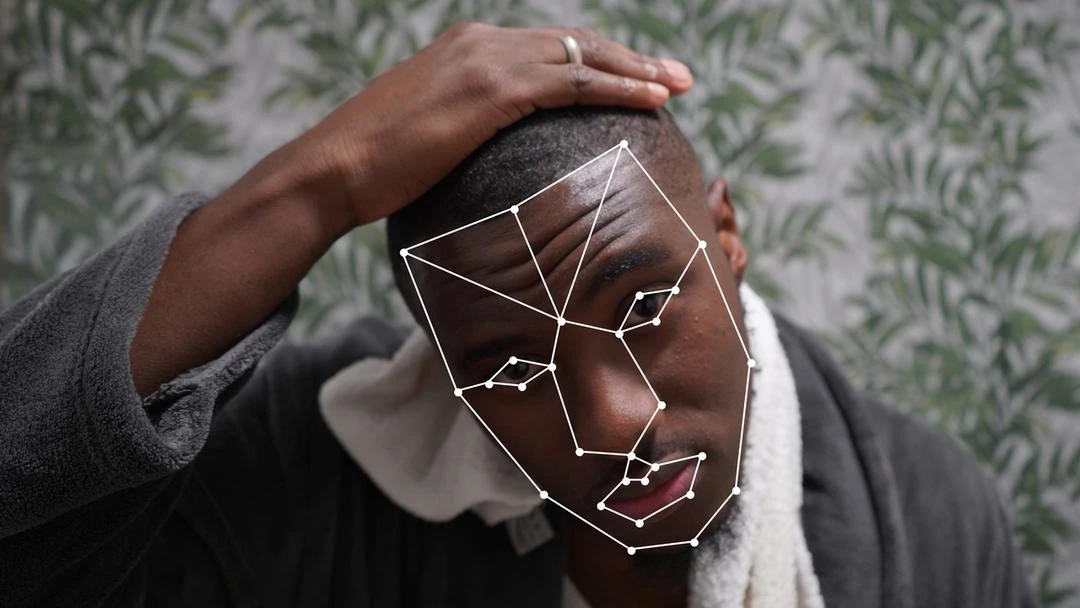

Kamera zur automatischen Gesichtserkennung am Bahnhof Berlin-Südkreuz.

CC BY Benjamin Kees

Beim aktuellen Test könne man die als beobachtet markierten Bereiche noch umgehen, kündigte die Bundespolizei an. Tatsächlich sind die Bereiche jedoch so gewählt, dass zum Beispiel diejenigen, die auf eine Rolltreppe angewiesen sind, dem Blick der Kameras nicht ausweichen können. Wenn es zu einem späteren Echt-Einsatz solcher Systeme kommt, wird es einen unüberwachten Ausweichbereich ohnehin nicht mehr geben. Alle, die am öffentlichen Leben teilnehmen, müssen dann damit umgehen, dass sie in ihrer täglichen Nutzung der öffentlichen Verkehrsmittel von Computern in Echtzeit vermessen, analysiert, bewertet und in allen möglichen privaten Momenten identifiziert werden können. Gleichzeitig können diejenigen, nach denen gefahndet wird, sich mit einfachsten Maßnahmen wie Sonnenbrillen, Mützen, Bärten, Make-up oder dem einfachen Blick nach unten, etwa aufs Smartphone, der Identifizierung entziehen.

Aussagekraft des Versuchs

Die Tests am Südkreuz sind nicht die ersten zur biometrischen Gesichtserkennung. Schon vor zehn Jahren machte das Bundeskriminalamt mit dem Projekt „Foto-Fahndung“ einen Anlauf am Mainzer Hauptbahnhof.[1] Einer der Hauptgründe, warum dieser und vergleichbare Tests scheiterten, war, dass die überwachten Menschen einfach nicht in die Kamera blickten. Auch ohne tieferes technisches Verständnis ist offensichtlich, dass ein Mensch, der vom Computer per Gesichtserkennung erkannt werden soll, kooperieren muss, in dem er zumindest grob in Richtung Kamera schaut. Nur so können individuelle Merkmale wie Augen, Wangenknochen und Nasenrücken vom Blick der Kamera und der Analysesoftware erfasst und zur Identifizierung herangezogen werden.

Ganz offensichtlich will die Bundespolizei dem Problem der mangelnden Kooperation nun aus dem Weg gehen, um den Test am Südkreuz möglichst erfolgreich dastehen zu lassen – den Testpersonen wurden nämlich „attraktive Preise“ dafür in Aussicht gestellt[2], sich besonders häufig vom System erfassen zu lassen. Bei solchen Anreizen ist von den Testpersonen, die vielleicht sogar unbewusst und mit den besten Absichten den Test unterstützen, mit einer überdurchschnittlichen Kooperation zu rechnen. Selbst in dem Falle, dass die Teilnehmer nicht durch das Versprechen von Preisen aktiv kooperieren, ist doch davon auszugehen, dass sich die Probanden der Erkennung nicht absichtlich dauerhaft entziehen, wie es bei einem späteren Einsatz von den dann tatsächlich gesuchten Personen zu erwarten ist.

Der Versuchsaufbau am Südkreuz ist somit völlig realitätsfern. Das gilt auch deshalb, weil die Testpolulation nicht die Bevölkerung repräsentiert. Das verzerrt die Ergebnisse zusätzlich.[3] Nach wissenschaftlichem Maßstab und auch nach gesundem Menschenverstand hat der Test folglich kaum Aussagekraft: Vom Test abgeleitete Befunde über die Tauglichkeit von Gesichtserkennung für einen späteren Einsatz sind stark anzuzweifeln.

Qualität und Fehler der Gesichtserkennung

Um die Qualität von Gesichtserkennung zu bewerten, misst man, wie häufig es bei der Identifikation zu Fehlern kommt – wie häufig ein gesuchter Mensch tatsächlich im Bild erkannt wird und wie häufig jemand fälschlicherweise erkannt wird, also mit einem anderen, gesuchten Menschen verwechselt wird.

Diese Rate bewegt sich bei Gesichtserkennung sogar unter Laborbedingungen, also mit hochaufgelösten Kameras und bei sehr guter Ausleuchtung, immer noch zwischen 1:1000 bis 1:10000. Das bedeutet, dass bei einem späteren Einsatz sogar unter Idealbedingungen pro Tausend beobachteter Menschen einer als gesucht erkannt wird, der nicht gesucht wird, und einer, der tatsächlich gesucht wird, nicht erkannt wird. Im öffentlichen Raum sind wir sehr weit weg von solchen technischen Idealbedingungen, daher liegen die Raten von falsch zugeordneten und nicht erkannten Menschen weitaus höher. Auf eine Stadt wie Berlin hochgerechnet, in der Millionen Menschen täglich die öffentlichen Verkehrsmittel nutzen, ist die Zahl der verpassten Gesuchten und der Fehlalarme immens hoch und wahrscheinlich nicht praktikabel.

Am Südkreuz werden nun alle Menschen, die dem markierten Bereich nicht ausweichen oder aufgrund von körperlichen Einschränkungen nicht ausweichen können und diejenigen, die werbeähnlichen Markierungen gar nicht wahrnehmen, nun für mindestens sechs Monate von mehreren Kameras erfasst, ihr Gesicht vermessen und mit den Gesichtern aus der Testdatenbank abgeglichen. Auch hier wird es über den langen Zeitraum statistisch gesehen zu einer beträchtlichen Anzahl von Fehlern kommen, so dass Unbeteiligte fälschlicherweise erkannt werden. Bilder von allen Erkannten werden für die spätere Auswertung aufgehoben, wie der Pressesprecher der Bundespolizei heute bei der Einführung des Tests bestätigte. So ist damit zu rechnen, dass auch biometrisch vermessene Gesichter von Unbeteiligten wesentlich länger als die bei Videoüberwachung üblichen 48 Stunden gespeichert werden.

Ausbau der Videoüberwachung

Aus wissenschaftlicher Sicht ist vor mehr als zehn Jahren deutlich geworden, dass Videoüberwachung in den meisten Anwendungsgebieten keinen signifikanten präventiven Nutzen hat. FIfF-Vorstandsmitglied und Experte für Videoüberwachung und deren Automatisierung Benjamin Kees kommentiert: „Ich bin empört und besorgt, dass trotz ausbleibender Präventionswirkung die Videoüberwachung immer weiter ausgebaut wird, dabei völlig unverhältnismäßig Grundrechte abgebaut werden und dies der Bevölkerung als notwendiges Eingeständnis für einen vermeintlichen Sicherheitsgewinn verkauft wird. Automatisierte Bewertung von Verhalten und Identifikation verunsichert Menschen bei der Teilnahme am öffentlichen Leben und ist ein weiterer durch Technikgläubigkeit fehlgeleiteter Versuch, ein gesellschaftliches Problem mit Computern zu lösen, die das nicht leisten können.“

Verhaltensbewertung und Identifizierungssysteme im öffentlichen Raum reihen sich als invasive Elemente in eine nicht enden wollende Reihe von fragwürdigen Maßnahmen ein, die längst viel zu viele Bereiche des privaten und öffentlichen Lebens beeinflussen. Das FIfF lehnt die Anfänge automatisierter Videoüberwachung entschieden ab. Ein System zu testen, das im aktiven Einsatz massiv gegen die Grundrechte verstoßen würde, ist absurd und verschwendet Steuergelder, die anderswo für echte Prävention und Sicherheit verwendet werden könnten.

Bei Fragen zu dieser Pressemitteilung wenden Sie sich bitte an Benjamin Kees:

- E-Mail: benjamin.kees@fiff.de

- Betreff: „PM Südkreuz“

- PGP: D0D7 F237 C0EF AA7B 829D E58D 1AFC C949 D0BC 1C67

Quellen

[1] https://www.bka.de/DE/UnsereAufgaben/Forschung/Foto-Fahndung/foto-fahndung_node.html

[2] https://www.bundespolizei.de/Web/DE/04Aktuelles/01Meldungen/Nohomepage/170619_gesichtserkennung.html

[3] https://netzpolitik.org/2017/ortstermin-am-suedkreuz-die-automatische-gesichtserkennung-beginnt/

Über das FIfF

Das Forum InformatikerInnen für Frieden und gesellschaftliche Verantwortung (FIfF) e. V. ist ein deutschlandweiter Zusammenschluss von Menschen, die sich kritisch mit Auswirkungen des Einsatzes der Informatik und Informationstechnik auf die Gesellschaft auseinandersetzen. Unsere Mitglieder arbeiten überwiegend in informatiknahen Berufen, vom IT-Systemelektroniker bis hin zur Professorin für Theoretische Informatik. Das FIfF wirkt in vielen technischen und nicht technischen Bereichen der Gesellschaft auf einen gesellschaftlich reflektierten Einsatz von informationstechnischen Systemen zum Wohle der Gesellschaft hin. Zu unseren Aufgaben zählen wir Öffentlichkeitsarbeit sowie Beratung und das Erarbeiten fachlicher Studien. Zudem gibt das FIfF vierteljährlich die „FIfF-Kommunikation – Zeitschrift für Informatik und Gesellschaft“ heraus und arbeitet mit anderen Friedens- sowie Bürgerrechtsorganisationen zusammen. Hier finden sich unsere 10 Werte.

Dazu passende Themen

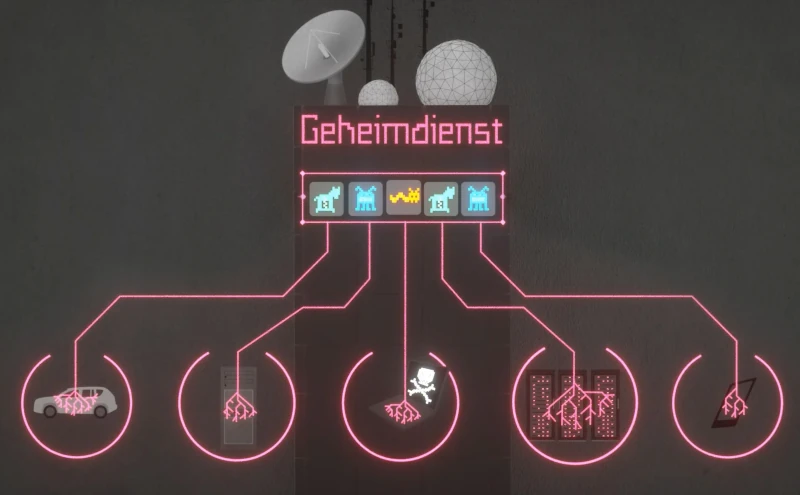

Überwachung, Polizei und Geheimdienste

Die Überwachung der Bürger durch Geheimdienste und Polizei, aber auch die Vorratsdatenspeicherung von Kommunikationsdaten darf nur in einem engen rechtsstaatlichen Rahmen stattfinden. Hierzu gibt es Urteile des Bundesverfassungsgerichts und des Europäischen Gerichtshofs für deren Einhaltung sich das FIfF einsetzt. Die Überwachung der Bürger durch Geheimdienste und Polizei, aber auch die Vorratsdatenspeicherung von Kommunikationsdaten darf nur in einem engen rechtsstaatlichen Rahmen stattfinden. Hierzu gibt es Urteile des Bundesverfassungsgerichts und des Europäischen Gerichtshofs für deren Einhaltung sich das FIfF einsetzt.

Videoüberwachung

Seit vielen Jahren beobachtet und kommentiert das FIfF den Technikmythos des vermeintlichen Sicherheitsgewinns durch Videoüberwachung. Seit vielen Jahren beobachtet und kommentiert das FIfF den Technikmythos des vermeintlichen Sicherheitsgewinns durch Videoüberwachung.

Biometrie und Gesichtserkennung

Gesichtserkennung vermisst Menschen digital aber nicht neutral – ist dabei fehleranfällig, übergriffig und ermöglicht Überwachung auf persönlicher Ebene. Das FIfF beobachtet Begehrlichkeiten, Tests und den Einsatz kritisch. Gesichtserkennung vermisst Menschen digital aber nicht neutral – ist dabei fehleranfällig, übergriffig und ermöglicht Überwachung auf persönlicher Ebene. Das FIfF beobachtet Begehrlichkeiten, Tests und den Einsatz kritisch.